原油期货开户 智谱的视频模型来了,它远非Sora,但却让这家公司更像OpenAI|对话智谱AI CEO 张鹏

发布日期:2024-10-05 23:29 点击次数:78

7月22日—7月27日原油期货开户,2024年“驾驭未来”全国青少年车辆模型教育竞赛总决赛在浙江杭州黄龙体育中心举行,全国42支顶尖代表队、超2000名青少年运动员参与逐梦之旅。由东莞市24所学校、65名选手组成的东莞代表队,参与了15个竞赛项目的比拼(包括9项个人赛与6项团体赛)。

智谱清影:基于自研模型,全量上线,体验丝滑

视频生成模型领域又多了一个重磅玩家。

7月26日,智谱AI旗下“智谱清言”App正式上线了AI视频生成功能“清影”,支持文生视频、图生视频。清影此次面向所有用户全量上线,无需预约,人人可用。

清影基于智谱自研的视频生成大模型CogVideoX,通过技术优化,将6秒视频的生成时间缩短到了理论上的30秒。视频参数方面,清影目前支持生成6秒时长的视频,分辨率为1440x960。根据智谱介绍,这个视频生成模型并非完全沿用因Sora而成为了某种“共识”的DiT架构,而是“智谱自研的一个将文本、时间、空间三个维度全部融合起来的transformer架构”。

话不多说,我们先来看看效果:

写实风格

打开新闻客户端 提升3倍流畅度Prompt:写实描绘,近距离,猎豹卧在地上睡觉,身体微微起伏

艺术风格

打开新闻客户端 提升3倍流畅度Prompt:末日来临,穿着宇航服的航天员缓缓朝着飞船走去,眼神中透露着对地球的不舍,注意细节刻画,废土风

符合废土风的冷色调,透过头盔玻璃显示出的眼神展示了复杂情感。

打开新闻客户端 提升3倍流畅度Prompt:摄像机围绕着一大堆老式电视旋转,这些电视播放着不同的节目——20世纪50年代的科幻电影、恐怖电影、新闻、静态、70年代的情景喜剧等,背景设在纽约博物馆的一个大型画廊里。

博物馆建筑细节营造出一种怀旧和艺术结合的氛围,电视播放的内容随着机位的移动保持了很好的连续性。

脑洞类

打开新闻客户端 提升3倍流畅度Prompt:广告拍摄视角,黄色背景,白色桌子上,画面中一个土豆被扔下来变成一份薯条

可以清晰看到土豆逐渐变成薯条的过程,并且非常符合Prompt中的“广告”感。

再来看看清影的图生视频能力。

首帧图:

泳池里的小鸭子:

打开新闻客户端 提升3倍流畅度Prompt:Little yellow duck toy floating on the water in the swimming pool, close-up

无论是水面的波动,溅起的水花,还是鸭子表面的光泽变化,都符合物理规律,像电影特写镜头。

结合以上案例我们可以发现,清影在指令跟随方面表现的十分不错,这离不开智谱AI的语言模型所具备的语言理解能力。值得一提的是,在快手此前开源的文生图模型可图Kolors中,就包含了ChatGLM3大语言模型能力的加持。

此外,清影不仅仅是一个单一的视频生成工具,它还整合了智谱清言的其他AI功能,为用户提供从创意构思到成品发布的一站式服务。用户可以使用AI搜索收集素材,用AI撰写文案和脚本,然后生成视频,最后还能添加背景音乐,完成完整的创作过程。

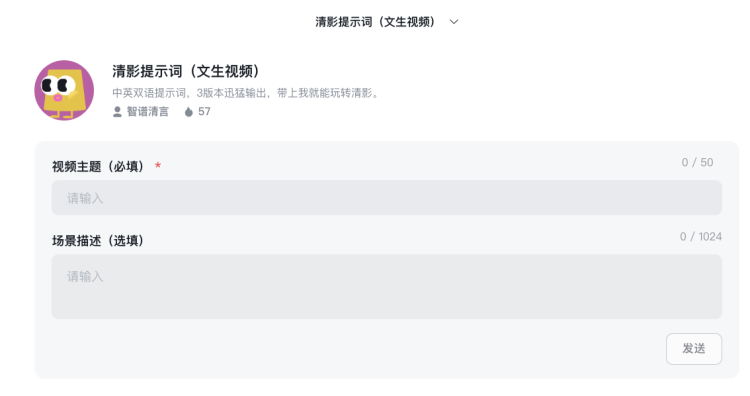

对于不擅长写提示词的用户,智谱还为用户准备了清影提示词智能体。

需要注意的是目前所有文生视频大模型的输出都具有不稳定性,所以想要得到满意的结果,需要通过“抽卡”多次尝试,这也是官方给出的tips之一。

并非Sora级产品,而是一个“

阶段性成果

”

熟悉最近一系列对标和赶超Sora的视频生成产品的人们会立刻意识到,当前的清影显然不是Sora级别的。它在视频长度、分辨率和生成质量等方面都还有很大的提升空间。

用智谱CEO张鹏的话来说“Sora 作为先行者,在生成式视频领域实现突破。我们沿着这条路径,给大家汇报智谱阶段性成果。”

智谱早在2021年就开始在多模态方向进行布局,2021年研发了文生图模型CogView,CogView的论文发布时间甚至早于DALL-E,此后又相继发布了CogView2,CogVideo、CogView3等成果。

其中,基于大模型的文本到视频生成模型CogVideo,采用了多帧率分层训练策略生成高质量的视频片段,提出一种基于递归插值的方法,逐步生成与每个子描述相对应的视频片段,并将这些视频片段逐层插值得到最终的视频片段,CogVideo引起了脸书、谷歌、微软等国际大厂的关注和引用。

打开新闻客户端 提升3倍流畅度具体来看,在技术层面,通过优化技术,该模型的推理速度提升了6倍,目前能在理论上30秒内生成6秒的视频,大大提高了生产效率。在可控性方面,智谱自研了一个视频理解模型,用于生成高度吻合的文本描述,从而构建了海量高质量的视频-文本对。这一创新也提升了模型的指令遵循度,使生成内容更符合用户需求,体现了模型对物理世界的理解。

此外,智谱的研究初步验证了scaling law在视频生成算法方面的有效性,为未来的发展指明了方向。他们还自研了一个高保真度、高流畅度的3D VAE,用于训练时的视频压缩,有效减少了冗余信息,提高了内容的连贯性。

打开新闻客户端 提升3倍流畅度事实上,现在的视频生成模型背后的路线可以简单分成两类:

一类就是要追逐现阶段技术共识之下视频生成的质量天花板,它们在视频时长、分辨率等方面不停“卷”出新高度;另外一类把视频生成定位为一个“终极”的多模态方案里的一个重要部分,它需要从一开始就考虑视频如何与其他模态相融合,视频不仅是生成的对象,也是模型理解能力和知识增长的重要部分,典型的就是OpenAI把Sora称为“物理世界模拟器”背后的思路。

智谱也有点像后者。看看张鹏在最近和我们交流中强调的技术点——指令跟随能力,语言模型的底座与视频能力的关系,一个并非完全照搬DIT的新的架构,和这个视频模型对于智谱追求的那个能解决通用问题的统一大模型的意义。

据张鹏介绍,此次视频生成产品背后的模型也是一个从设计上就想要把文本、时间和空间三个维度全部融合起来的transformer架构,它摒弃了传统的cross attention模块,而是在输入阶段就将文本embedding和视频embedding结合起来,以便更充分地进行两种模态的交互。

“这两种模态的特征空间有很大差异,我们通过expert adaptive layernorm对文本和视频两个模态分别进行处理来弥补这一差异,这样可以更有效地利用扩散模型中的时间步信息,使得模型能够高效利用参数来更好地将视觉信息与语义信息对齐。”智谱介绍。其中注意力模块采用了3D全注意力机制,先前的研究通常使用分离的空间和时间注意力或者分块时空注意力,它们需要大量隐式传递视觉信息,大大增加了建模难度,同时它们无法与现有的高效训练框架适配。在位置编码模块设计了3D RoPE,更有利于在时间维度上捕捉帧间关系,建立起视频中的长程依赖。

“大家对于技术路线的演进似乎现在仍然是没有共识的,但我们对于路线的确定是很早以前就设定好的。”张鹏最近和我们的交流里说。他认为,本质问题是你在统一建模和非统一建模上的取舍。而上述这些模型设计背后的思路,显然说明智谱更看重统一建模。

“视频这件事情,我们认为对自然语言的理解作为抽象层面的一个大脑,如果能把理解和生成的能力解决好,把它和其他模态进行对齐,能够更好地帮助我们生成高质量、可控的内容。而不是先把生成解决了,再去解决理解和对齐的问题。光靠语言可能就训练出一个缸中大脑,无法跟现实世界产生直接对应关系,很难解答现实世界的问题,只能在抽象层面解决。”他说。

“从这一点上来看原油期货开户,OpenAI和我们对于AGI的信仰和追寻的路径是很相像,不管哪种模态,最终都会统一起来。”

打开新闻客户端 提升3倍流畅度对话张鹏:“OpenAI和我们对于AGI的信仰很像”

在此次清影正式上线之际,硅星人也和智谱AI CEO张鹏进行了一次小范围的交流,以下为对话实录,在不改变原意的前提下有所调整:

智谱什么时候开始做视频生成的技术探索?

张鹏:2021年开始在做视觉生成相关的内容,CogView论文发布比DALL-E还更早一些。在CogView模型基础之上,我们开始做视频生成,2022年开始做CogVideo,当时还处于研究的阶段,包括谷歌、微软也在关注和引用我们的工作,Sora出来以后,我们认识到视频生成还是要跟语言模型结合,所以就接着投入。

我们是持续在做多模态的,去年也发布了最新的cogview3,跟DALL-E、SD相比的,效果还是非常不错的。但视频和图像的生成,确实还隔着一步,因为数据、算力等问题。

围绕视频这件事,智谱需要补足的一些能力或者资源是什么?

张鹏:这实际上是我们的技术路线里一个循序渐进的过程。自然语言解决的是理解和生成能力,指令遵循的能力,实际上是从基础的认知层面解决这个问题。然后理解和生成的能力具象化到,图片、视频、声音或者其他的模态上,技术上的路径是这样的。

其次也受算力、数据等条件约束。对于视频生成来讲,高质量的数据积累,其实是短短几年时间积累起来,全球范围内也是一样,所以需要时间积累。

怎么解决数据获取问题?

张鹏:我们自己没有原生的视频资源,所以主要的方式还是通过公开的数据集,以及央视频这样的合作方,有很正式的,纪录片或新闻风格,还有生活类的、动画,二次元等等,一定要保证风格的多样性。

什么是高质量的视频数据?视频高清,运镜、分镜都很不错,这对于做一个模型还不够。还需要包含原始数据和对原始数据的加工的技术。

我们在思考数据获取这件事情的时候,一部分是在梳理技术路径,另一部分是在思考怎么获取质量更高的视频数据。

影响视频生成效果最核心的因素是是什么?

张鹏:可以类比语言模型的发展历程,早期的大家数据集差别不大,数据的利用率很高,算法框架、训练和工程的经验更重要。

发展到一定阶段,算法已经收敛的差不多了,架构就是局部上的改进,这时候数据的影响又会比较大。怎么来优化的数据集,用更少的算力,更少的数据,得到相对更好的结果。

现在很多新模型,能够很快速地爬升性能曲线,就在于前期算法摸索的过程没有了,数据上前人也踩过一些坑了。

后发者反而有优势?

张鹏:后发有后发的优势,体现在前期成本、增长的速度上。剩下无非就是两件事,一个是技术本身的更新迭代,一个是技术到产品的 PMF ,看你要聚焦到哪件事情上。

后发者的劣势呢?

张鹏:你站在别人的肩膀上,对底层并没有很深入的了解。当碰到需要技术内核的更新迭代才能解决的问题的时候,可能就无能为力,只能跟在别人背后。

从天花板上线和长久的发展的角度来看,还是做得越早,认知越深,自己掌握的东西越多。

视频生成的技术路线处在哪个阶段?

张鹏:现在还是一个探索的过程。包括Sora的DiT架构,到底是怎么做的?现在也没有人能够完全复现,OpenSora 也尝试去复现Sora,但效果远远没有Sora好。

我们自己也是在不断的在摸索,虽然有Cogvideo这些经验,但毕竟还是比较早期,怎么去改进,是一个挺有挑战的事情。

清影还是长在GLM之上的?

张鹏:内核是语言模型,基于我们的通用底座。

这里面有一些很有意思的地方,比如怎么让视频生成更可控?更可控的思路和文本生成是不是一致的?这些都是我们团队一直在尝试解决的一些问题。

扩散模型生成图像可以做得比较好,但怎么来跟语言的描述对齐?DiT 这个架构怎么来解决这个问题,这是大家要探索的。

Sora发布之后,国内外的厂商都陆续拿出了一些相关的产品,是因为验证了技术路线?

张鹏:跟语言模型类似,当有人证明了这件事是可行的。大家再去努力相对来说会更容易一些,因为有个切实的目标摆在那了。研究突破的方向相对可以收拢一点,就会快一些。

选择在这个节点发布文生视频产品的原因是什么?

张鹏:视频生成我们很早就在做,现在有一个阶段性的成果,大家也可以尝试一下,我们还是摸索自己特点的一些东西,内容连贯性上比目前开源的技术要好,包括用3D VAE减少画面当中冗余信息引起的画面闪烁,生成内容的跟输入的指令的遵循性方面的提升等等。属于我们迈出的第一步,后续也会快速地迭代,尽快的能实现Sora类似的水平。

视频生成技术走向更成熟大概需要的时间?

张鹏:很难预测,但我相信一定会加速。最难的地方在于起步的这一段爬坡的过程,后面会出现类似语言模型的拐点。

智谱为什么相信从文本到图像、视频的多模态路线?

张鹏:大家对于技术路线的演进似乎现在仍然是没有共识的,但我们对于路线的确定是很早以前就设定好的。这个可能就是先发的优势,对底层的本质的理解会更深。

比如视频这件事情,我们认为对自然语言的理解作为抽象层面的一个大脑,如果能把理解和生成的能力解决好,把它和其他模态进行对齐,能够更好地帮助我们生成高质量、可控的内容。而不是先把生成解决了,再去解决理解和对齐的问题。

我们的目标是做原生的多模态大模型。是统一建模的还是非统一建模?本质上在于你思考这个问题的结论。我们更看重统一建模,认为这件事情可能会更重要一些。

如果把 AGI 作为目标,多模态是一个绕不过去的一个事吗?

张鹏:不可能从纯的文本去实现这个目标,客观物理世界人类的语言只能描述其中的很小一部分,如果单纯从语言的角度去实现类人的AGI是很难的。光靠语言可能就训练出一个缸中大脑,无法跟现实世界产生直接对应关系,很难解答现实世界的问题,只能在抽象层面解决。

从这一点上来看,OpenAI和我们对于AGI的信仰和追寻的路径是很相像,不管哪种模态,最终都会统一起来。

Powered by 启灯网|按月按天配资官网|正规实盘炒股配资网 @2013-2022 RSS地图 HTML地图